La version française de l’article est disponible à la suite de la version anglaise

1. Introduction

Human beings have always dreamed of artificially improving their physical and intellectual capacities [1]. More than ever before, technology makes this possible today. There are many examples of implants, artificial prostheses, neurological and cardiac stimulators which allow us to envision that biological life is increasingly enhanced by technology. Most of these sensory implants are designed for restorative purposes. The best-known examples are cochlear and visual implants. Our aim is at showing how the intrusion of information and communication technologies (ICT) into our daily lives makes the hypothesis of a cybernetic declination of these implants consubstantial to their future development, making them genuine cybernetic organisms (cyborgs) according to the original definition of N. Harbisson [2]. Today, the latter implies an external exogenous digital component from the cyber-sphere, which was difficult to imagine at the time, as the Internet did not exist.

If we consider the extraordinary potential offered nowadays by nanotechnologies allowing miniaturisation of electronics and engineering of organic materials (e.g. polymer, collagen etc.) that are flexible, conformable and biocompatible, we understand that all the ingredients are gathered to witness the emergence of a generation of cyborgs operating at different levels of our sensory system. In this respect, vision is a prime area. Almost 70% of the information processed by our brain is processed through the eye [3]. Our main access to the cyber-sphere (the internet has become the ICT matrix nowadays) is through our smartphone screens and tomorrow through augmented reality glasses. Finally, the physiology of visual perception and the cellular organisation of the visual cortex into specialised functional areas is conducive to intervention at different levels of the perceptual chain [4]. This explains the constant quest to restore visual failures. If we put aside refractive or oculomotor pathologies, to focus on retinal sensory endings, science has progressed considerably in this field in recent years, thanks to the miniaturisation of retinal and cortical implants, optogenetic engineering, and the training of undamaged macular peripheral areas [5].

Similarly, the porosity between restoration and augmentation is obvious in the case of the eye. Restoration aims to reproduce all or part of what a healthy eye would see (e.g. by means of a camera). This can be achieved by projection onto a retinal implant or cortically as we will see later. However, there is nothing to prevent an artificial or cybernetic image being substituted for the image of a real scene. The current use of mixed reality (MR) or augmented (AR) is a compromise. The wearer can be provided with information about obstacles in his vicinity (e.g. potential upcoming collisions by voice guidance as in [6]). The latter then has an additional advantage over the sighted person. If we take the reasoning further, we can imagine an artificial vision, totally different from human vision, using other attentional percept (a bat-like vision for example). While the technological difficulty is not much greater, the cognitive learning mechanisms involved are far more different. We will discuss some of the challenges that these new biotechnologies will have to face: conceptual, acceptability and ethical challenges. Until now, the motivation for the creation of cyborgs has been mainly therapeutic (to correct, repair and rehabilitate). Today, we are seeing the emergence of some with a cybernetic component in the rudimentary form of visual Human Machine Interfaces (HMIs) [7], preludes to more elaborate cyborgs whose vocation is to interact strongly with the cyber-sphere and whose purposes are no longer exclusively curative or reparative. Taking the example of achievements in reconstructive surgery, we will show how such implants can become authentic cyborgs [8].

2. Retinal and cortical implants

We will limit ourselves here to three approaches that illustrate the main trends. The first is to replace damaged retinal light-sensitive cells with light-sensitive sensors [9].

2.1. Retinal implants

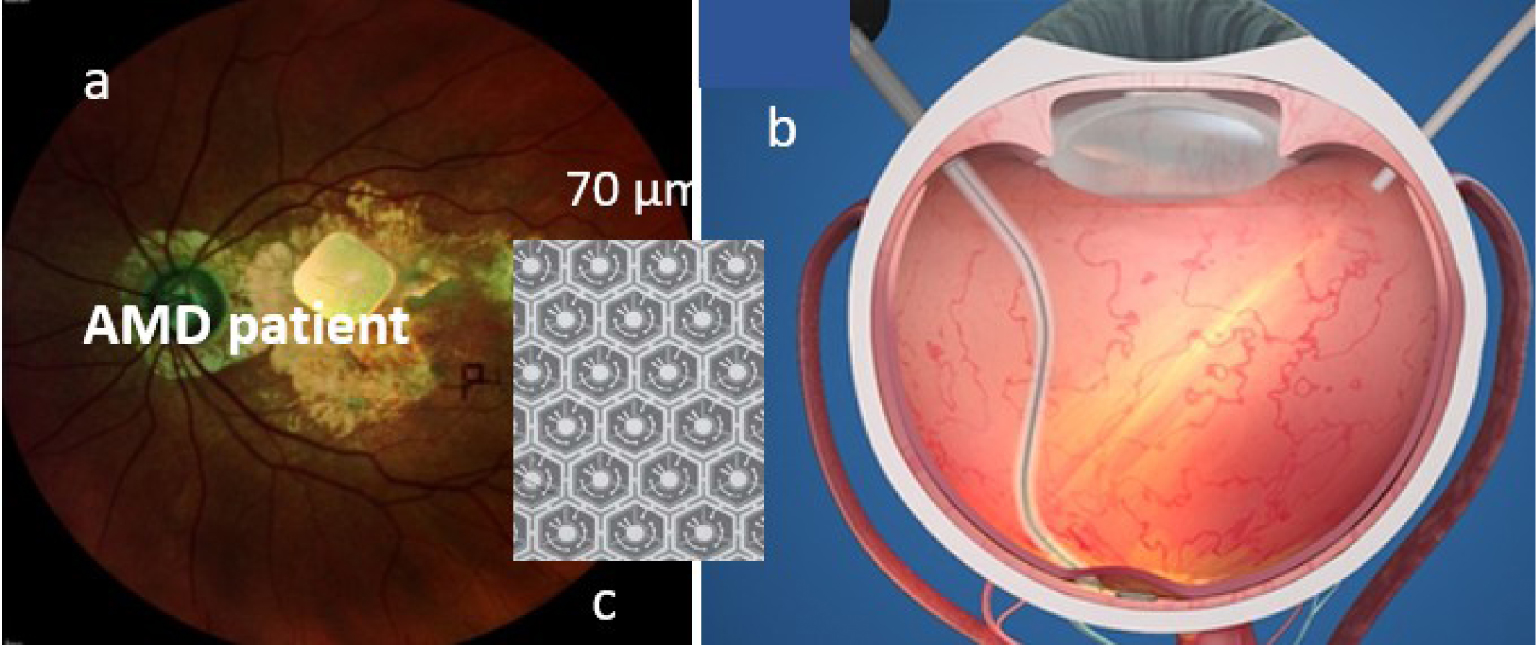

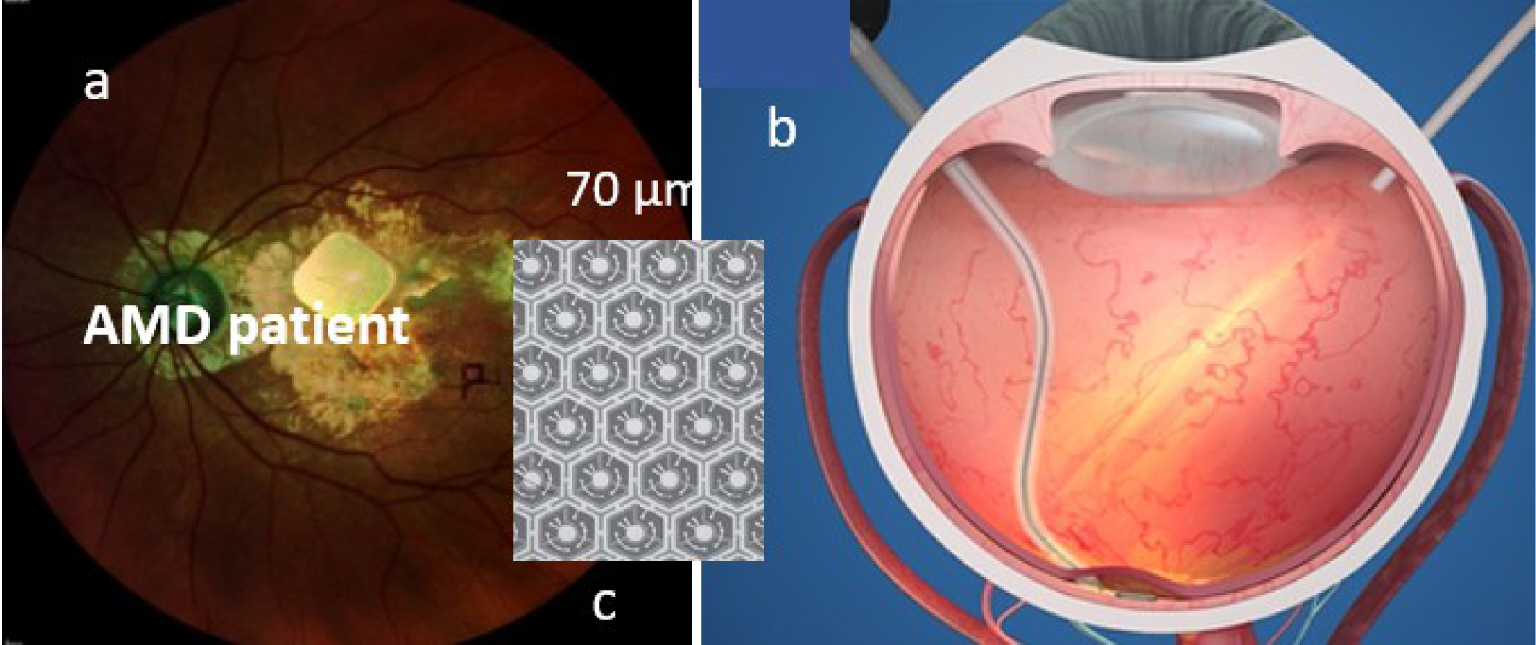

An example is given with the PRIMA subretinal implant, proposed by the company Pixium. This implant is 2 × 2 mm and 30 μm thick. It is made up of 70 μm photovoltaic pixels, which generate a local electric current on the surface of the retina, wireless [9]. Each pixel has a central electrode powered by several photodiodes. This technique is fairly easy to implement and moderately intrusive, as the photovoltaic nature does not require any external electronic connections. The modular nature of the technique allows for the addition of further implants later on if required over a larger retina area.

The implant acts as a mini solar panel, powered by an infrared signal emitted via a miniaturised digital projector, integrated in the pair of glasses worn by the patient. The subretinal implant exploits a physiological network that is still functioning (bipolar and ganglion cells). This implant consists of 378 electrodes. Each pixel has a local electrical feedback to provide more targeted electrical stimulation. The prosthesis consists of the implant, a pair of glasses with a camera, a digital projector and a microprocessor. Its main limitation is its reduced resolution, mainly due to the difficulty of electrical connection with the cells of the subretinal layer (Figure 1).

(a) View of the retina with its implant, (b) subretinal insertion technique (http://www.pixium.com), (c) photovoltaic detector mosaic.

2.2. Optogenetics

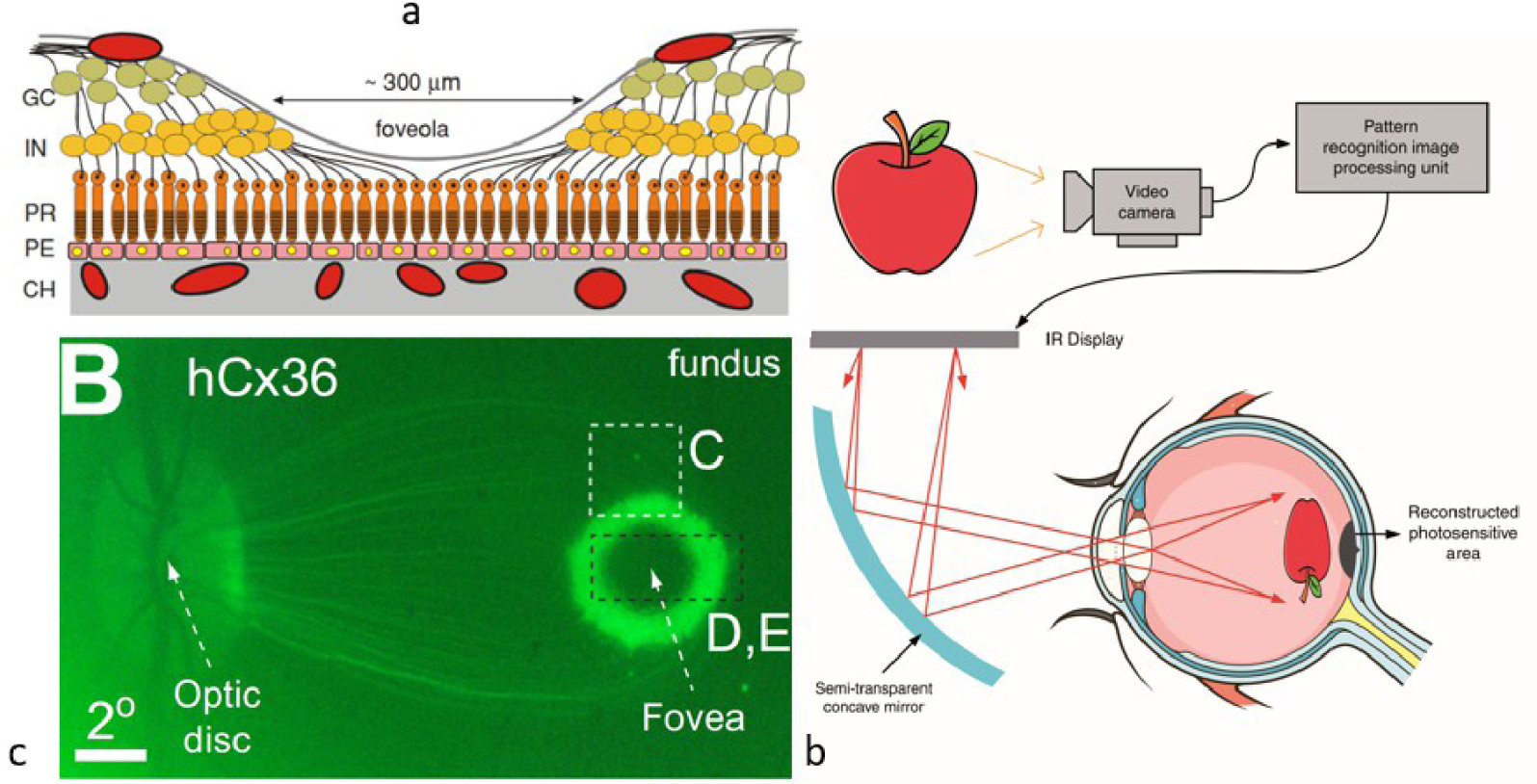

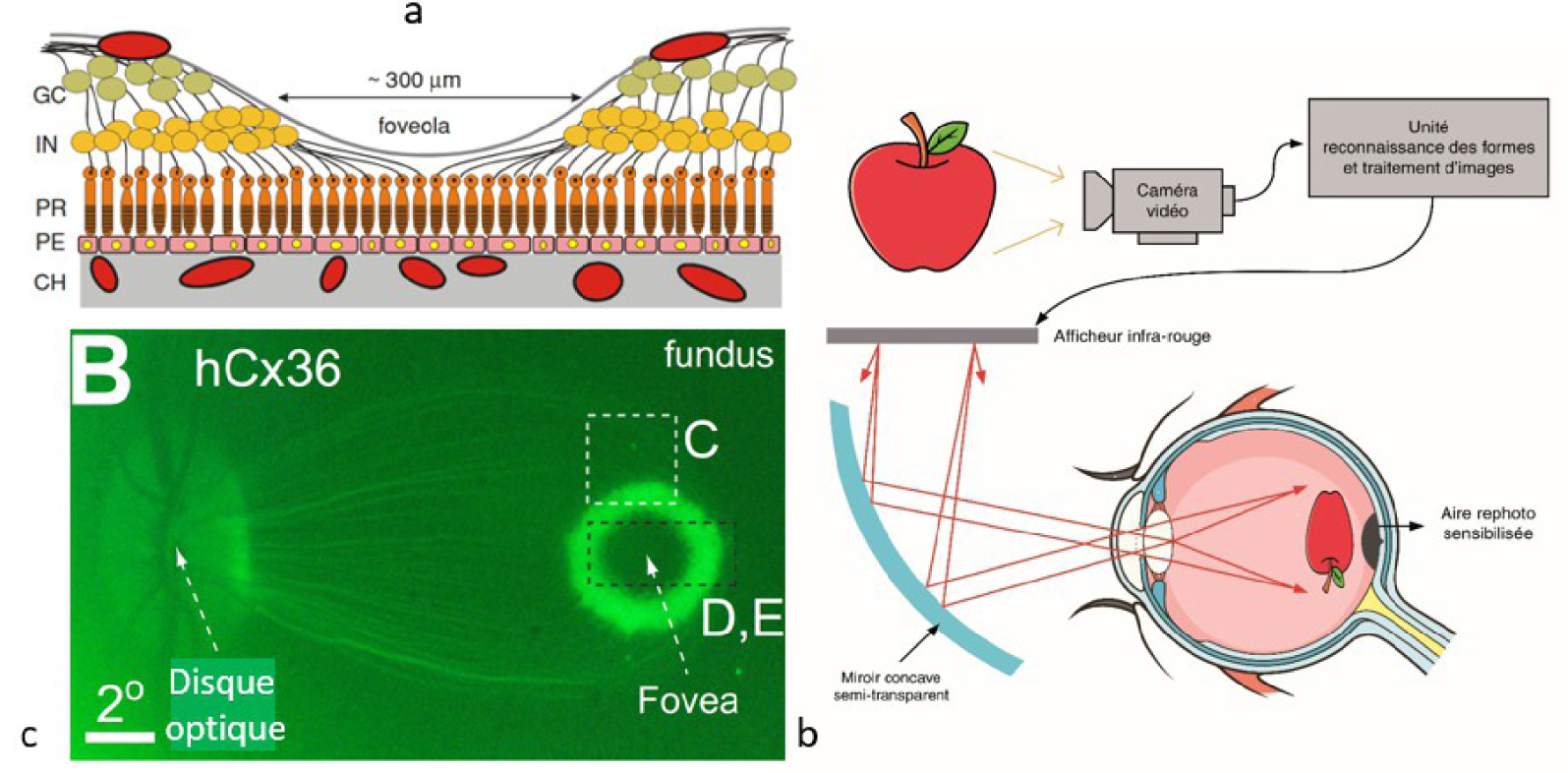

The second is the result of optogenetic engineering as proposed, for example, by Gensight-Biologics. It is based on the transfer of a gene associating a photosensitive protein to make certain neuronal cells sensitive to light stimulation [10]. It addresses sub-retinal cells (the retina being supposedly damaged), such as ganglion cells, and transforms them into photoreceptors. This technique involves not only the insertion of a gene encoding the protein (e.g. opsin) that confers photosensitivity to the target cells, but also the use of an optical projection device at the right wavelength (e.g. amber) to stimulate the transduced cells to transmit the signal to the brain. Given the organisation of the ganglion network (Figure 2a), anamorphic optics (e.g. corona type) may be useful.

(a) Representation of the human fovea with bipolar and ganglion cells outside the fovea. Retinal layers: GC-ganglion cells, IN-internal nuclear, PR-photoreceptors, PE-retinal pigment epithelium, CH-choroid. (b) Projection of the image of the spectacle screen onto the retina from [9]. View of the illuminated retinal area around the fovea.

What these two approaches have in common is the need for a planar imaging optics between the (external) projection system and the retina. This imposes an ocular fixation that can quickly become tiring and makes the imaging dependent on the natural movements of the eye. An ocular servo system can be added, for example by means of an eye-tracker. These solutions allow voluntary avoidance (e.g. eye or eyelid movement). Note that in the first case the projection device could be replaced by data transmission using an NFC protocol, as described below, which removes the need for eye control.

2.3. Cortical implants

The two previous techniques are not suitable for people with dysfunctional connections between eye and brain (e.g. degeneration of the optic nerve). Restoration in this case can only be done by electrical activation of the visual cortex neurons [11]. Very weak electrical currents (a few μA) applied through an electrode in the visual cortex induce an artificial perception of light, called a phosphene (they can also be seen by applying pressure to the eye). Images from a camera are used to convey information about the real world by stimulating a multiple electrode array (a matrix) in the visual cortex to create shapes: phosphenes1 [12] that act as visual pixels that can be combined to form a visual percept. This technique has given rise to numerous works and technological achievements. Continuous studies carried out between 1968 and 2002 in humans, with a relatively small number of electrodes, were fundamental, but did not allow the perception of a complete shape or the development of a complete functional prosthesis.

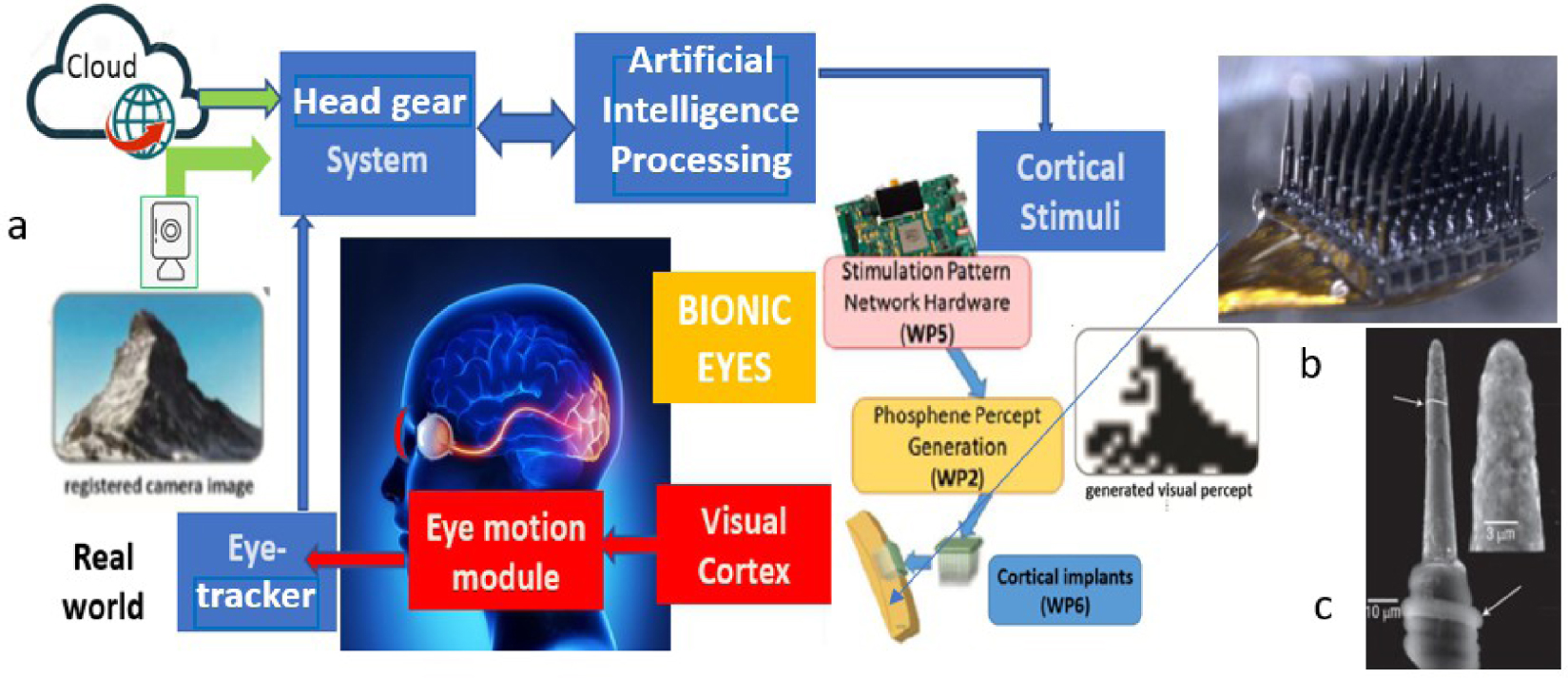

The technology has since progressed enormously, facing two major challenges: the size of the electrodes inserted in regions of the cortex close to the surface of the brain (inner side of the occipital lobe, near the ear), and the small number of electrodes (a few hundred, compared to the million fibres of the optic nerve). Recent experiments carried out by Roelfsema’s team at the Netherlands Institute for Neuroscience [13], with longer electrodes (a few mm) and a greater number (1024) have made it possible to create finer, deeper stimulations (at 30 Hz) and better resolved phosphenes. They were implanted in the visual cortex of monkeys in areas of the striate visual cortex, at different depths allowing stimulation of the retinotopic map (area V1) giving a representation of the visual field and of the internal granular layer (V4) allowing us to ensure the stimulations were well perceived by the primates. The prosthesis stimulated the V1 region and read V4. The group of phosphenes created letters T or L.

However, current silicone electrodes have a limited life span. They are increasingly less conductive and are being rejected because of their rigidity compared to the flexibility of brain tissue. Solutions with Graphene deposits are more resistant, have better elasticity and are more electrically efficient. Others based on biocompatible gallium phosphide nanowires suggest that this issue will be overcome in the near future [14]. Even if it is very intrusive, this solution reinforces the idea of visual cortex prostheses that could dispense with our eyes. This would require a larger number of electrodes to cover the few cm2 of the visual cortex (more than a million to emulate human vision). Even if it would require other techniques to stimulate these areas than electrodes, this technique gives access to different levels of the functional areas of the visual cortex and makes it possible to overcome the retinal lock.

Theoretically, this solution could be used to enhance an already functional view by superimposing phosphene-based percepts (subtitles, comments, icons, etc.) on real vision, a cortical version of the Google Glasses. The connected version of these implants is intrinsic to their development. It consists of substituting real image stimuli with artificial images as in Figure 3 (i.e. real, artificial, or a mix of both). Beyond the different degrees of intrusion (biological, cybernetic), this pathway opens up a promising field for acting at different levels of the visual cortex, as discussed above. Areas V2, V3 are clearly targeted. Visual attention and perception of cognitive processes are based on an exchange between several regions of the visual cortex. While from an anatomical point of view, these areas are well known, we know less about the electrical activity that allows us to direct this attention and to optimise our visual capacities (e.g. better synchronise these areas). Targeted intervention on some of these areas to boost this capacity is part of augmented vision. The Frontlab team at the Institut du Cerveau uses transcranial magnetic stimulation [15], which is less intrusive and more accessible than electrodes, and could be extended here. This implies knowing what we mean by augmented vision.

(a) Principle of electrode-based augmented vision (phosphenes) (e.g. Utah Probe) with real world or cybernetic input [16], (b) electrode array and integrated interface (http://www.blackrockneurotech.com), (c) elementary graphene oxide electrode from [17].

3. Augmented vision—pre-eminence of mixed reality

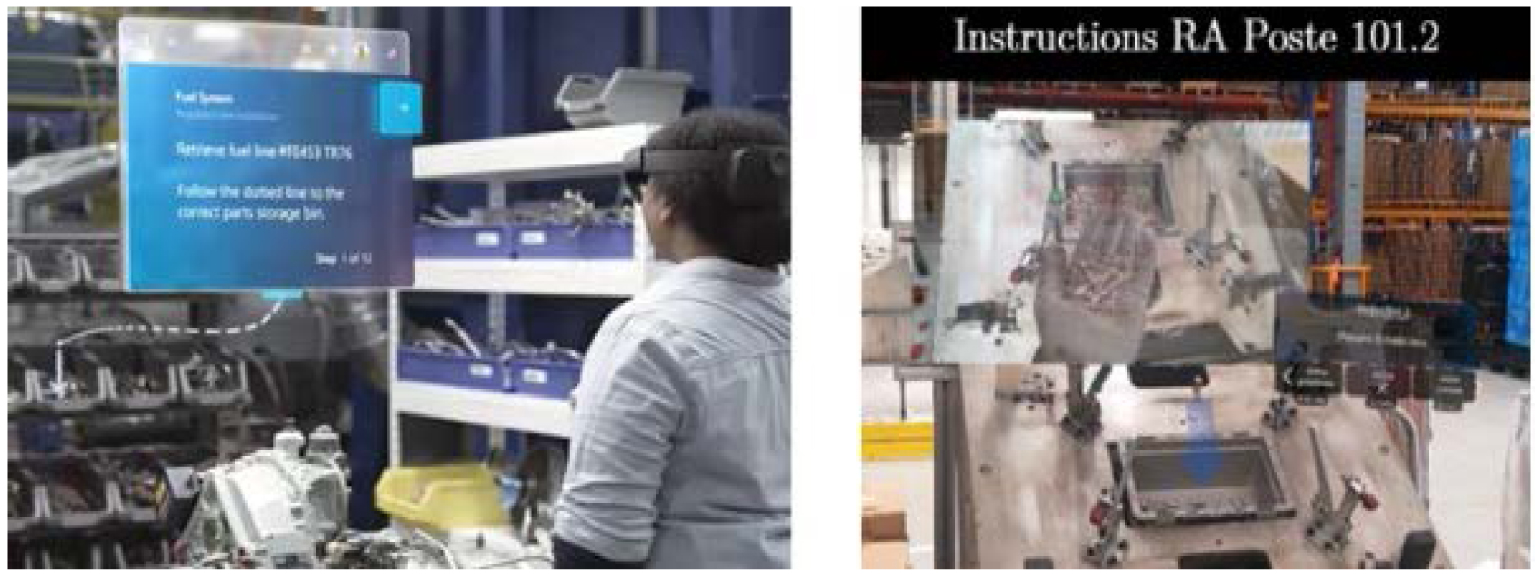

This is not about creating a new sense that humans do not have (e.g. giving our retina sensitivity to infrared), but about adding, superimposing something more to our natural vision. This can be symbolic information, images, subtitles, or even avatars that are integrated into our visual field. Mixed reality devices (e.g. goggles or headsets) that mix digital content with the real world are the best illustration of this [18]. All that is needed is to insert a semi-transparent plate into the visual pathway, which, while maintaining the perception of the real world, superimposes images from an external projection system. Such devices can be found in most cars nowadays. This would be nothing new if the pressure of the most business-oriented part of the cyber-sphere and technological progress would not push information closer to the user (Near Eye Display—NED), i.e. to our retina and our eye, to keep us under a constant information flow rate while preserving our mobility. Another key marker of this trend, beyond the greater complexity and richness of the visual content offered, is to require the user to perform haptic interventions on these objects as shown in the figure above. This may involve manipulating virtual objects in space, activating a menu, or pointing to a target, with the eye being able, with some very advanced devices, to act as a cursor or actuator in a 100% hands-free logic. Figure 4 shows what an assisted assembly line operator of the future will see [19]. In addition to the assembly station control (a boiler in this case), digital versions of the parts to be assembled and assembly instructions (embedded, interactive, scrolling menu) are superimposed in his visual field, with the possibility of manipulating virtual objects in space while assembling real parts, maintaining vigilance and control of the immediate attentional visual field.

An illustration of an assembly line (a) from Microsoft’s 365 guides (attention is drawn from the assembly line to the instructions and then to the workpiece tray), (b) with the presence of avatars (hand) in the IronMen project [19].

It is understandable that the sensory stimulation changes completely, putting our perceptual system to the test, especially if the rate increases for productivity purposes (Chaplin’s version of modern times 5.0) [20]. The display potential of mixed reality content that technology can produce today far exceeds the capacity of our brain to assimilate and analyse it, given that it all passes through only a few mm2 of retinal epithelial tissue. Augmented vision as produced by content and technology providers, with a resolution of 0.5 pixels per arc second (which will be improved) is far ahead of our understanding of the impact of such content streams on our sensory and cognitive systems.

However, we can get an idea of this from studies of HUDs (Head Up Displays) which suggest that the information produced and that of the real world belong to two distinct perceptual groups [21] and that switching from one to the other can lead to attentional costs and longer reaction times. These effects are considerably amplified during visualisations involving haptic input, which can lead to attentional blindness [22], a phenomenon that results in the fixation of cognitive resources on a single group of information, thus affecting the ability of the visual system to detect and respond rapidly to events outside that group [23]. This lack of attention is explained by the limited processing capacity of the cognitive system, which is unable to process information from different perceptual clusters simultaneously. Although it is likely that the realism of visual avatars will soon be such that the brain will find it difficult to distinguish between virtual and real, this distinction is based more on the nature of the operations associated with these visual percepts interpreted at another brain level. One example is the dichotomy between planning an action and controlling it online, suggesting that each serves a specific purpose with distinct visual presentations [24]. Planning is influenced by a wide range of visual and cognitive inputs, whereas control depends mainly on the visual characteristics of the target (size, orientation, colour, shape). Neuropsychological and imaging evidence suggests that these operations are served by separate visual centres in the posterior parietal lobes [25]. The issue remains far from simple and is a current field of investigation in neuroscience. At the current stage of knowledge, processing rich augmented scenes may require additional cognitive resources with an uncertain outcome on our visual performance and ability to respond quickly to these visual stimuli. The goal of increasing our performance would then risk to be missed.

Does this mean that the eye is the weak element? It is the only point of passage between the percepts of a highly enriched mixed universe and the cognitive mechanisms formed by millennia of evolution to a representation of the natural world. Even if we know the plasticity of our brain (game designers develop a cognitive accommodation to these mixed contents that makes them more resilient), our visual cortex may struggle to assimilate such complexity. Many studies show contradictory results and the question remains open [26]. The intrusion of a cybernetic world into our natural sensory space requires learning to prevent possible conflicts between increasingly complex visual stimuli of different kinds (signs, messages embedded in the real world) and perceptual mechanisms, heritage of a long evolutionary process. Pointing to the eye as the weak link is therefore deliberately provocative. Cognitive overload, leading for instance to a form of attentional blindness, has causes that are clearly located in the cortex. The thesis of a direct stimulation of the striate cortex, bypassing the retina, is therefore tempting. Would it enable us to resolve such conflicts and thereby increase our perceptive performance? The question deserves to be asked.

However, we cannot restrict ourselves to retinal capacity alone, given the importance of eye and head movements in perception (an example is the reconstruction of relief by motion parallax in monocular vision). We must consider the visual flow including these voluntary or involuntary eye movements for a good understanding and optimisation of the cognitive faculty. A better understanding of their role requires a precise control of retinal stimulation, integrating the oculomotor mechanisms, in order to assimilate the information efficiently and thus hope to reduce possible attentional disorders. A mediation between the brain and this real-cybernetic world, independent of these movements, is therefore relevant for the study of these mechanisms.

Cortical implants make this possible, as does an instrumented contact lens. The fact that they offer retinal stimulation, free from eye movements, constitutes an intermediate step, less intrusive than implants, for the realisation of brain–computer interfaces (BCI). They constitute the third category of visual assistants offering a natural connection to the cyber-sphere.

4. The contact lens as a visual assistant

The first instrumented contact lenses (including electronic, physico-chemical functions, etc.) are about 15 years old. They met the needs of ergonomic devices for therapeutic and diagnostic assistance [27]. This was followed by the emergence of commercial biometric sensors for real-time disease monitoring [28], such as the Verily lens, which detects blood glucose in tears using analyte sensors, or Sensimed’s Triggerfish, which measures variations in eye pressure 24 h a day for the treatment of glaucoma. These lenses are often associated today with ocular drug elution techniques.

4.1. The visual HMI lens

Their use as HMIs dates back a few years, either to provide the eye with new functionalities (cursor, actuator, etc.), or as an interface for mixed reality. For example, the Sony lens [29] proposes to record what the user sees, using a nano-camera, which shows the high level of miniaturisation of current cameras, projectors and displays, suggesting that soon the user will be able to take photos with his eyes, play videos, open web browsers, in his line of sight, and that these cyborgs will replace our smartphones. This attests to the interest in technologies that facilitate this new mixed reality experience, on contact lenses, allowing access to menus in peripheral vision, or to select a specific functionality by focusing on it. EPGL and InWith have announced the construction of InLens1.0, an electronic-augmented mobile autofocus lens compatible with Apple iOS and Google Android operating systems [30]. Mojo-Vision offers a solution for AR with a micro pupil display [31]. Even if nothing totally convincing has been achieved yet, this is an indication of the trends as most of the building blocks have been tested.

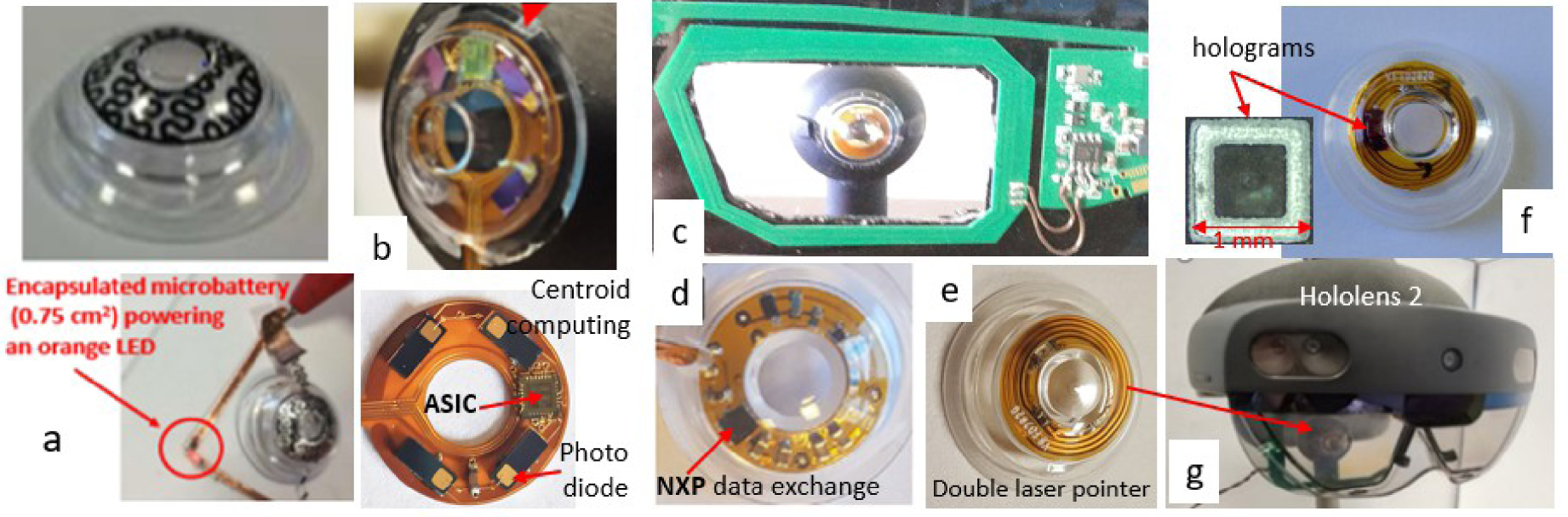

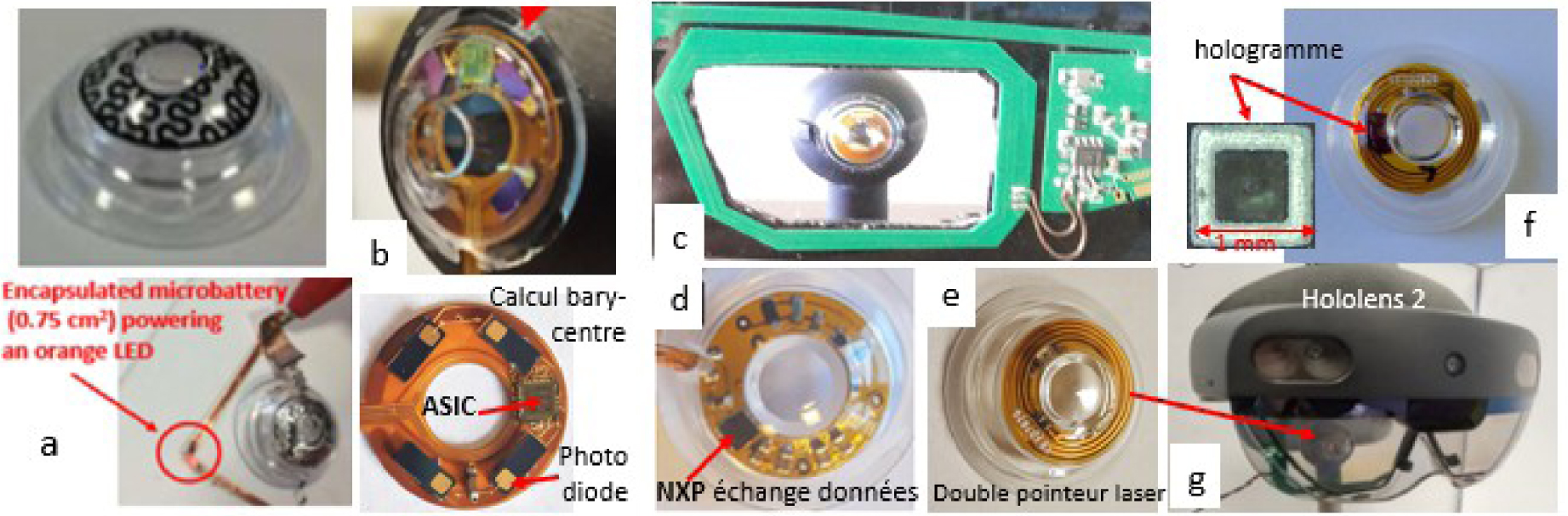

IMT Atlantique is one of the pioneers in this emerging field. We have tested the encapsulation of several building bricks (flexible micro-batteries [32], data communication circuits [33] by near field communication (NFC) protocol, ASIC2 and photodiodes for a centroid calculation [34]) as well as complete functions (double laser pointer [35], eye-tracker, blink detection [36]). We are also one of the few to perform biocompatibility tests (CE marking of our laser pointer). Figure 5 illustrates some key functions encapsulated in scleral contact lenses packaged by Laboratoire-LCS.

Lenses incorporating (a) flexible battery powering an external LED [32], (b) ASIC and 4 photodiodes [34], (c) antenna on spectacle mount and artificial eye [37], (d) NFC circuit [33], (e) dual laser pointer at 850 nm [35], (f) with hologram [38], (g) laser pointer coupled to an AR headset (e.g. Microsoft Hololens 2).

Let’s look at the NFC/RFID transmission protocol for a moment. Its role is twofold: to resource the lens (coupling by magnetic induction Figure 5c) and to exchange data with it, by means of two antennas, one on the lens, the other nearby (e.g. on a eyewear). The exchanges are bidirectional [33]. This technology is very miniaturised nowadays. Low-power passive NFC/RFID tags are incorporated into patch biosensors [39]. These transponders are a sign of a potential connection to the cyber-sphere allowing exchange with any digital medium, as they can be conceived today. They can be easily integrated into a contact lens and could replace the photovoltaic cells of the retinal implants seen above, to supply the retina with synthetic images. Their miniaturisation makes them compatible with microsurgery. The production of antennae by metallic inkjet deposition on a flexible biocompatible substrate makes this possible. In addition to this natural link to the cyber-sphere, they would make these implants free from ocular tracking, thus providing the wearer with a complete mobility.

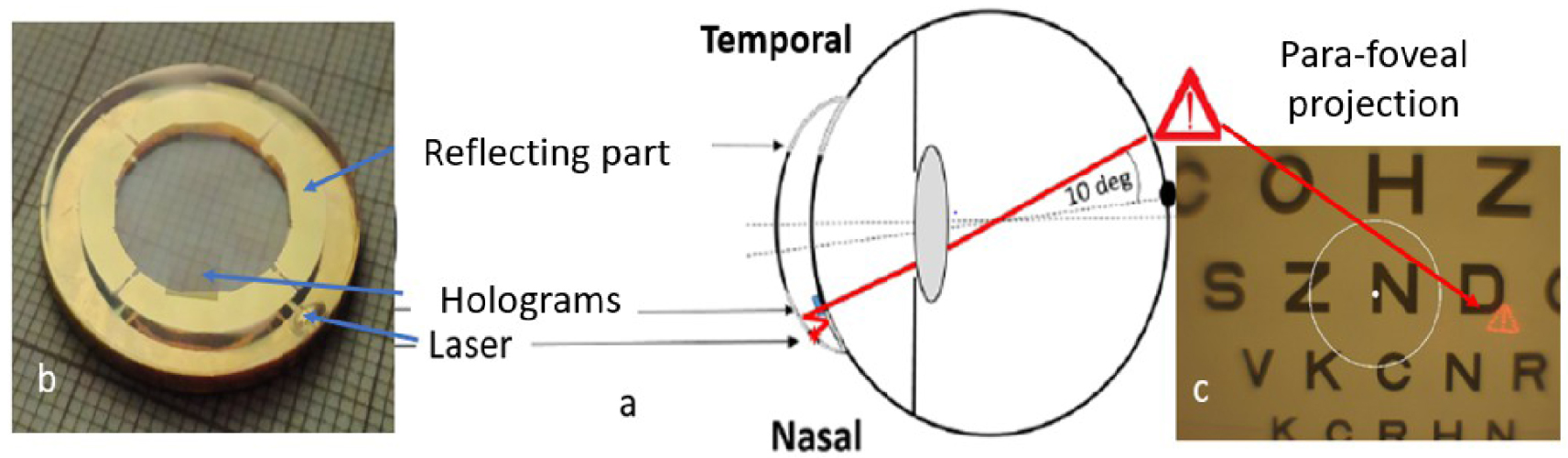

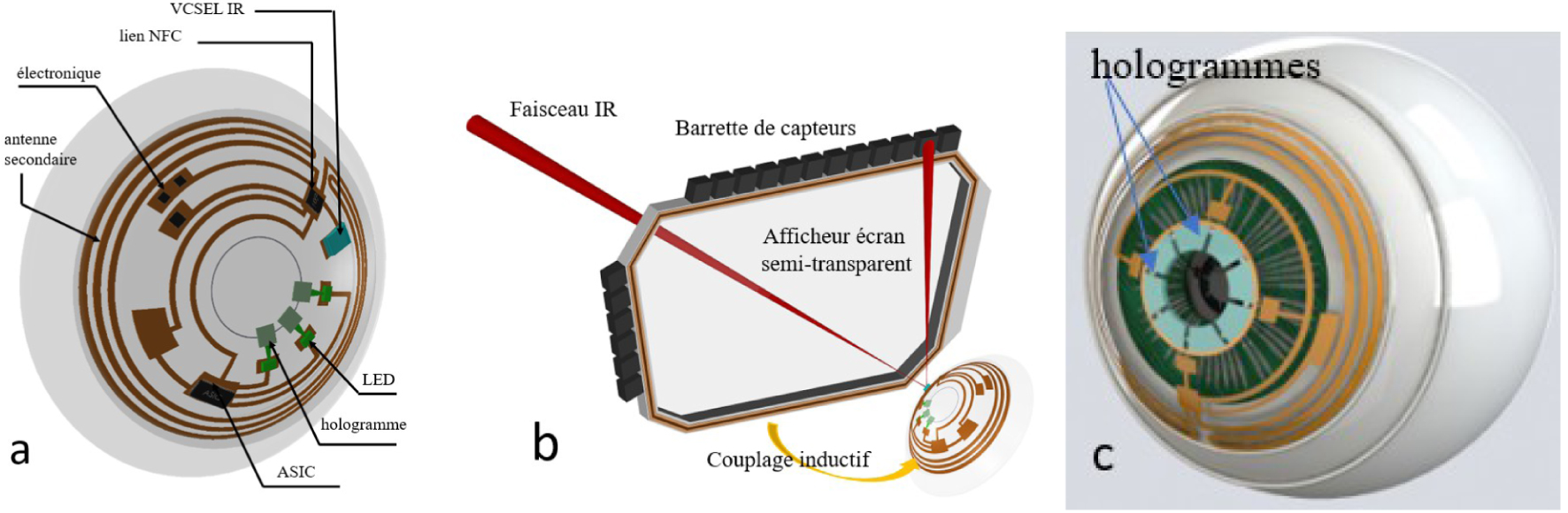

Very recently we have incorporated holograms (1 mm2 by 100 μm thick) to project icons either onto the retina or outwards to activate sensors at the periphery of an AR helmet (Figure 6b) or to designate visual targets [38]. This function is a key function allowing the lens to communicate instructions to a mixed reality system represented here by its semi-transparent screen, equipped with sensor arrays to analyse the position of the eyes (Figure 6).

(a) Example of functions already integrated in an instrumented lens, (b) example of exchange with an augmented reality headset such as Hololens2 (photo Figure 5g), (c) example of PRAR lens.

4.2. The PRAR contact lens

The ability to image icons on the retina from the lens, superimposed on natural vision (Perifoveal Retinal Augmented Reality PRAR) is the key step towards a Cyborg AR contact lens. While the number of images at this stage is still limited, it controls the projection of patterns onto specific retinal areas, remotely activated (e.g. by GPS as in [9]). We have carried out a proof of concept at scale 2 [40] (Figure 7). The lens has 8 holograms (partially covering the iris) illuminated by lasers. The lasers are connected to a ring light guide, projecting monochrome images onto the parafovea (Figure 6c). The images, the areas stimulated, the colours and the exposure times are the subject of studies carried out with the Institut de la Vision. They concern rich exposure situations requiring optimisation of attentional resources.

PRAR lens, (a) principle and scale 2 implementation, (b) position of lasers, holograms and light guide, (c) projection area of a holographic pattern (danger sign) on the parafovea.

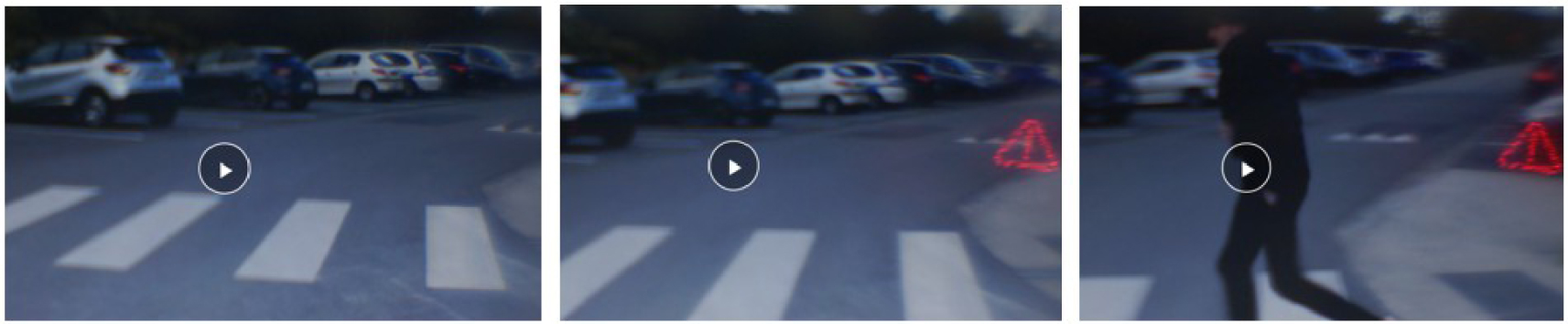

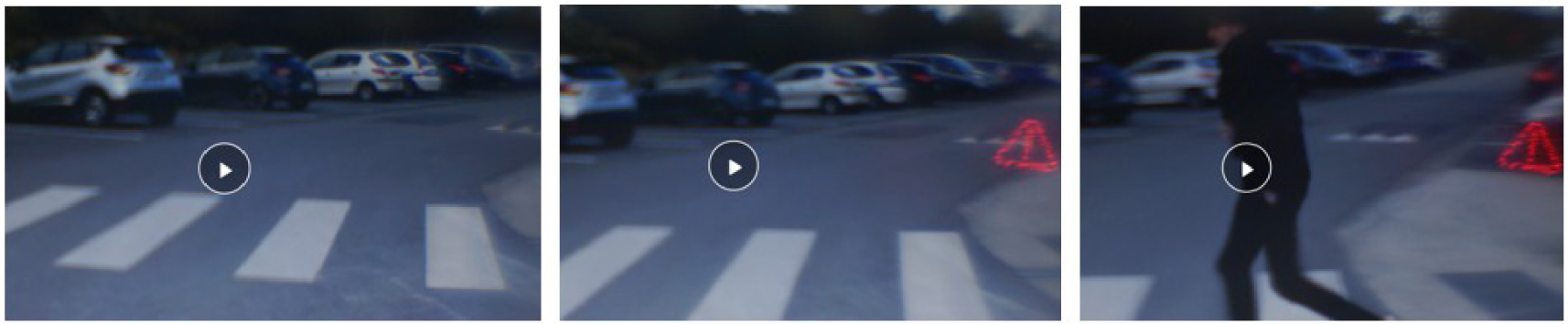

The patterns are chosen in relation to the application context, for attentional re-stimulation in case of cognitive overload or prolonged fixations leading to attentional masking effects. The lens stimulates retinal areas with icons or symbols independently of eye movements. This is important when attention needs to be maintained on objects or parts of scenes, unimpeded by distractors, or to improve visual performance in patients with central vision loss by stimulating, for instance, their preferred retinal locus [5]. PRAR allows the execution of visual commands or the perception of external cues without eye movement to scan other areas of the visual field. Eye movements are part of the vision-action loop, which is crucial for learning and alertness (Figure 8). The interactions between the eyes and the thalamus involve an important event-driven response mechanism in which the eyes play a key role. The principle of stimulation without eye movements is an innovative exploratory approach to better understand their role in the management of cognitive overload, as already mentioned.

What the wearer sees. The system signals the arrival of a concealed pedestrian. A danger signal appears, the pedestrian is about to cross the road, the signal disappears once the pedestrian has passed (from the video in [40]).

Although it only acts on the retina, PRAR has similarities with cortical implants (Section 2.3). It stimulates the retinal areas with elementary forms, admittedly in limited number (phosphenes are also limited) but sufficient for attentional vigilance functions. It allows projection onto predetermined areas (linked to a retinal function) with a controlled colour and exposure time, to avoid possible residual disorders. Both approaches can be controlled by an external organ, which makes them genuine cyborgs. If these icons are limited in number, their combinations produce a large number of different messages. Thus if 4 holograms generate 15 different associations with the double we get 395, which is enough to provide the brain with a variety of messages. We obtain a vocabulary close to that of the phosphenes in the current state of technology. It should be noted that they can be projected onto different parts of the retina or concentrated in a single area, by adjusting their optical carriers accordingly. The PRAR is similar to a head-up display such as those used in driver assistance systems, which allow the driver to keep their head up and their eyes on the road, while having access to real-time information in their field of view. Furthermore, it will soon be possible to replace these holograms with an integrated micro-display. This is the path being pursued for instance by the company Mojo-vision [31].

The main limitation of this solution is the volume that can be used without creating discomfort for the wearer. In this context, scleral lenses are the natural platforms for these cyborgs because they offer more surfaces (part of the sclera can be used [41]). They are static and without contact with the cornea. The use of the pupillary area is still a matter of debate. Some consider that it should remain free to ensure ophthalmic vision quality and for safety reasons. The development of graphene electronics suggests that this area (15 to 20% more volume) will soon be usable. It seems difficult to go any further and therefore to think that a cyborg lens could one day replace the functionalities of a helmet or AR glasses. They are best used as a relay or visual assistant. For targeted retinal stimulation, they are the investigation tools of choice. The fusion of visual attention with naming tasks is, for instance, of great interest for many applications. The possibility of visual designation contributes to lightening the workload of operators, allowing them to concentrate on their main task while establishing a new link between planning, control functionality and sensory coordination [24].

5. Conclusions and limits of the exercise

These few lines might suggest that the human eye is the main obstacle to a form of visual hyper-sensoriality and to the deployment of cybernetic vision (i.e. rich augmented vision). Evolutionists have rephrased it another way: why not have a larger fovea? Because the connections and cortical space needed to process the entire visual field in as much detail as the fovea would require a brain larger than the human brain. This remark may echo the observation of certain disorders during intensive and uncontrolled exposure to rich mixed reality content. However, there are many causes for this (different lighting, contextualisation, movement models etc.). The fusion of real and virtual worlds is a complex issue which is the subject of much work today [42].

There is therefore a natural limit to the use of cyborgs connected to our cortex or visual system, but this does not preclude beneficial uses such as for the restoration and treatment of visual disorders and blindness. The deployment of cybernetic augmented vision, on the other hand, comes up against a purely evolutionary model of the human being [37], based on the plasticity of the brain, its capacity to learn and adapt. Faced with the fear of the acceleration of a form of artificial intelligence carried by a technology whose growth law follows a different time scale, suggesting that it should exceed the capacity of the human brain fairly quickly, the idea of cybernetic transplants seems to some to be the only response to this apparent threat. Some of the theses put forward by the new American transhumanist movement (influenced by an inexhaustible literary and cinematographic culture) advocate the replacement of the biological eye by an artificial eye, postulating that, apart from the brain, biotechnology will soon be able to manufacture limbs, organs, sensors (e.g. exoskeleton, heart valve, cochlear implant, etc.), all of which are usable but replaceable spare parts. One might think that such a prospect does not enthuse the profession, but it cannot be dismissed and is fully part of a global reflection on cybernetic augmented vision.

Have we entered the era of Homo-Machinus-Cyberneticus [43]? The abundance of hypotheses, sometimes among the most fanciful, fuelled by SF series and the Internet, is very fertile. If it is part of human creativity, today more than ever, many of these hypotheses are technologically feasible. Some are even beyond the realm of the imaginable, which requires a real sense of foresight. If the idea of becoming augmented humans, like Steve Austin,3 remains an old dream, we can ask ourselves how to put this cyborg engineering to good use. Beyond the question of restoration or augmentation, we can see these objects as formidable investigation tools for neurosciences, to better analyse the mechanisms of perception, cognition, learning, concerning one of the most developed and complex neurosensorial organs, human vision. To this end, instrumented contact lenses could be the decisive step in a controlled and progressive experimentation. In addition to their low-intrusiveness, which facilitates experimentation on humans, the limited volume of what can be integrated is a guarantee against the ambitions of future demiurges and for a controlled migration towards more intrusive cybernetically augmented organs, before they become consumables. The third way may be through science. The real novelty of these objects is the multidisciplinary scientific field on which they are based, at the crossroads of nanotechnology, biotechnology, information technology and cognitive science (NBIC). In this respect, they are emblematic of a convergence between the infinitely small, the manufacture of life, thinking machines and the study of the human brain, ultimate symbol of the transformation that our industrial society is undergoing today.

Conflicts of interest

The author has no conflict of interest to declare.

Version française

1. Introduction

L’être humain a toujours rêvé d’améliorer artificiellement ses capacités physiques et intellectuelles [1]. Plus que jamais la technologie le permet aujourd’hui. On trouve de nombreux exemples d’implants, prothèses artificielles, stimulateurs neurologiques, cardiaques qui laissent penser que la vie biologique sera de plus en plus augmentée par la technologie. La plupart de ces implants sensoriels sont conçus dans un but réparateur. Les plus connus sont les implants cochléaires et visuels. Notre but est de montrer comment l’intrusion des technologies de l’information et de la communication (TIC) dans notre vie de tous les jours rend l’hypothèse d’une version cybernétique de ces implants, inséparable de leur développement futur, en faisant d’authentiques organismes cybernétiques (cyborgs) selon la définition originelle de N. Harbisson [2]. Celle-ci implique aujourd’hui une composante numérique exogène issue de la cyber-sphère, difficile à imaginer à l’époque, internet n’existant pas.

Si l’on considère l’extraordinaire potentiel offert de nos jours par les nanotechnologies permettant une miniaturisation de l’électronique et une ingénierie des matériaux organiques (e.g. polymère, collagène etc.) flexibles, conformables et biocompatibles, on comprend que tous les ingrédients sont réunis pour assister à l’émergence d’une génération de cyborgs opérant à différents niveaux de notre système sensoriel. Sous cet angle, la vision est un terrain de choix. Près de 70% de l’information traitée par notre cerveau passe par l’œil [3]. Notre principal accès à la cyber-sphère (internet est devenu la matrice des TIC, de nos jours) se fait par nos écrans de smartphone et se fera demain par des lunettes de réalité augmentée. Enfin la physiologie de la perception visuelle et l’organisation cellulaire du cortex visuel, en aires fonctionnelles spécialisées, est propice à une intervention à d’autres niveaux de la chaîne perceptive [4]. Si l’on écarte les pathologies réfractives ou oculomotrices, pour se concentrer sur les terminaisons sensorielles rétiniennes, la science, dans ce domaine, a progressé considérablement ces dernières années, grâce à la miniaturisation d’implants rétiniens et corticaux, l’ingénierie opto-génétique, et l’entraînement des zones périphériques maculaires saines [5].

De la même façon la porosité entre restauration et augmentation est une évidence dans le cas de l’œil. La restauration vise à reproduire, tout ou partie de ce que verrait un œil en bonne santé (e.g. au moyen d’une caméra). Ceci peut s’obtenir par projection sur un implant rétinien ou par voie corticale comme on le verra plus loin. Rien n’empêche néanmoins de substituer à l’image d’une scène réelle, une image artificielle ou cybernétique. L’usage courant de la réalité mixte (RM) ou augmentée (RA) en est un compromis. On peut ainsi fournir au porteur une information sur des obstacles dans sa proximité (e.g. potentielles collisions à venir, comme en [6] par guidage vocal). Ce dernier dispose alors, par rapport au bien-voyant, d’un atout supplémentaire. Si l’on pousse le raisonnement, on peut imaginer une vision artificielle, totalement différente de la vision humaine, utilisant d’autres percepts attentionnels (une vision de type chauve-souris par exemple). Si la difficulté technologique n’est guère plus grande, les mécanismes d’apprentissage sont autrement plus complexes. Nous allons aborder quelques-uns des défis auxquels ces nouvelles biotechnologies devront faire face : défi conceptuel, d’acceptabilité, mais aussi éthique. Jusqu’ici la motivation pour la création de cyborgs était thérapeutique (corriger, réparer, rééduquer). On en voit émerger dotés désormais d’une composante cybernétique sous la forme rudimentaire d’Interfaces Homme Machine (HMI) [7], préludes à des cyborgs plus avancés ayant vocation à interagir fortement avec la cyber-sphère, à des fins non plus exclusivement curatives ou réparatrices. En prenant exemple de réalisations en chirurgie réparatrice, nous montrerons comment de tels implants peuvent devenir d’authentiques cyborgs [8].

2. Les implants rétiniens et corticaux

Nous nous limiterons ici à trois approches illustrant les grandes tendances. La première consiste à remplacer les cellules photosensibles rétiniennes endommagées par des capteurs photosensibles [9].

2.1. Les implants rétiniens

Un exemple est donné avec l’implant sous-rétinien PRIMA, proposé par la société Pixium. Cet implant fait 2 × 2 mm pour 30 μm d’épaisseur. Il est constitué de pixels photovoltaïques de 70 μm, permettant de générer un courant électrique local à la surface de la rétine, et ce sans fil [9]. Chaque pixel dispose d’une électrode centrale alimentée par plusieurs photodiodes. Cette technique est assez facile à implanter et moyennement intrusive, le caractère photovoltaïque ne requérant aucune connexion externe électronique. Son aspect modulaire permet d’ajouter d’autres implants par la suite si besoin sur une partie plus importante de la rétine.

L’implant agit comme un mini panneau solaire, alimenté par un signal infrarouge émis via un projecteur numérique miniaturisé, intégré dans la paire de lunettes portée par le patient. L’implantation sous-rétinienne exploite un réseau physiologique qui fonctionne toujours (cellules bipolaires et ganglionnaires). Cet implant comprend 378 électrodes. Chaque pixel est doté d’un retour électrique local, visant à fournir des stimulations électriques plus ciblées. La prothèse est constituée de l’implant, d’une paire de lunettes dotée d’une caméra, d’un projecteur numérique et d’un microprocesseur. Sa principale limitation est sa résolution réduite, principalement liée à la difficulté de connexion électrique avec les cellules de la couche sous-rétinienne (Figure 1).

(a) Vue de la rétine avec son implant, (b) technique d’insertion sous-rétinienne (http://www.pixium.com), (c) mosaïque de détecteurs photovoltaïques.

2.2. L’optogénétique

La seconde est le fruit de l’ingénierie optogénétique telle que proposée, par exemple, par Gensight-Biologics. Elle repose sur le transfert d’un gène associant une protéine photosensible pour rendre certaines cellules neuronales sensibles à une stimulation lumineuse [10]. Elle adresse les cellules sous rétiniennes (la rétine étant supposée endommagée), comme les cellules ganglionnaires et les transforme en photorécepteurs. Cette technique implique outre l’insertion d’un gène codant la protéine (e.g. l’opsine) qui confère une photosensibilité aux cellules cibles, l’emploi d’un dispositif de projection optique à la bonne longueur d’onde (e.g. l’ambre) pour stimuler les cellules transduites afin qu’elles transmettent le signal au cerveau. Vu l’organisation du réseau ganglionnaire (Figure 2a), une optique anamorphique (e.g. du type corona) peut s’avérer utile.

(a) Représentation de la fovéa humaine avec les cellules bipolaires et ganglionnaires. Couches rétiniennes : GC-cellules ganglionnaires, IN-nucléaire interne, PR-photorécepteurs, PE-épithélium pigmenté rétinien, CH-choroïdes. (b) Projection de l’image de l’écran des lunettes sur la rétine, tiré de [9], (c) vue de l’aire rétienne éclairée autour de la fovéa.

Le point commun de ces deux approches (Sections 2.1, 2.2) est le besoin d’une optique d’imagerie planétique entre le système de projection et la rétine. Ceci impose une fixation oculaire qui peut devenir vite fatigante et rend l’imagerie tributaire des mouvements naturels de l’œil. Un système d’asservissement oculaire peut être ajouté au moyen d’un oculomètre, par exemple. Ces solutions permettent un évitement volontaire (e.g. mouvement de l’œil ou de la paupière). Notons que dans le premier cas le dispositif de projection pourrait être remplacé par une transmission de données au moyen d’un protocole NFC, comme nous le décrirons plus loin et qui supprime le besoin d’un contrôle oculaire.

2.3. Les implants corticaux

Les deux techniques précédentes ne sont pas adaptées aux personnes présentant des connexions dysfonctionnelles entre œil et cerveau (e.g. dégénération du nerf optique). La restauration ne peut se faire dans ce cas que par l’activation électrique des neurones du cortex visuel [11]. De très faibles courants électriques (quelques μA) appliqués à travers une électrode dans le cortex visuel induisent une perception artificielle de la lumière, appelée phosphène (on peut aussi les apercevoir en exerçant une pression sur l’œil). On utilise les images d’une caméra que l’on transforme pour véhiculer des informations sur le monde réel en stimulant un réseau multiples électrodes (une matrice) dans le cortex visuel pour créer des formes : les phosphènes1 [12] qui agissent comme des pixels visuels combinables pour former un percept visuel. Cette technique a donné lieu à de nombreux travaux et réalisations technologiques. Des études constantes menées entre 1968 et 2002 chez l’homme, avec un nombre relativement faible d’électrodes, ont été fondamentales, mais n’ont pas permis de percevoir une forme complète ni d’élaborer une prothèse fonctionnelle complète.

La technologie a depuis énormément progressé, faisant face à deux défis majeurs : la taille des électrodes insérées dans des régions du cortex proches de la surface du cerveau (face interne du lobe occipital, près de l’oreille), et le faible nombre d’électrodes (quelques centaines, à comparer au million de fibres du nerf optique). Les expérimentations récentes menées par l’équipe de P. Roelfsema au Netherlands Institute for Neuroscience [13], avec des électrodes plus longues (quelques mm) et en plus grand nombre (1024) ont permis de créer des stimulations (à 30 Hz) plus fines, plus profondes et des phosphènes mieux résolus. Elles ont été implantées dans le cortex visuel de singes dans des aires du cortex visuel strié, à différentes profondeurs permettant une stimulation de la carte rétinotopique (aire V1) donnant une représentation du champ visuel et de la couche granulaire interne (V4) permettant de s’assurer que les stimulations étaient bien perçues par les primates. La prothèse stimulait la région V1 et lisait la V4. Le groupe de phosphènes créait des lettres T ou L.

Les électrodes actuelles en silicone ont toutefois une durée de vie limitée. Elles sont de moins en moins conductrices et progressivement rejetées du fait de leur rigidité comparée à la souplesse du tissu cérébral. Des solutions avec dépôt de Graphene plus résistantes ont une meilleure élasticité et sont plus efficaces électriquement. D’autres à base de nano-fils en phosphure de gallium biocompatibles laissent penser que ce problème sera surmonté à brève échéance [14]. Même si elle est très intrusive cette solution nous conforte dans l’idée de prothèses de cortex visuel qui pourraient nous dispenser de nos yeux. Il faudrait pour cela un plus grand nombre d’électrodes pour couvrir les quelques cm2 du cortex visuel (plus d’un million pour espérer émuler la vision humaine). Même s’il faudrait trouver d’autres techniques que les électrodes pour stimuler ces zones, cette technique donne accès à différents niveaux des aires fonctionnelles du cortex visuel et permet ainsi de dépasser le verrou rétinien.

Théoriquement, on pourrait utiliser cette solution pour augmenter une vue déjà fonctionnelle en superposant à la vision réelle, des percepts à base de phosphènes (sous-titres, commentaires, icônes, etc.), une version corticale des Google Glasses. La version connectée de ces implants est intrinsèque à leur développement. Elle consiste à substituer aux stimuli d’images réelles ceux d’images artificielles comme sur la Figure 3 (i.e. des images réelles, artificielles, ou un mélange des deux). Au-delà des différents degrés d’intrusion (biologique, cybernétique), cette voie ouvre un champ prometteur pour agir à différents niveaux du cortex visuel, comme évoqué plus haut. Les aires V2, V3 sont clairement visées [13]. L’attention et la perception visuelles de processus cognitifs reposent sur un dialogue entre plusieurs régions du cortex visuel. Si d’un point de vue anatomique, ces régions sont bien connues, nous en savons moins sur l’activité électrique qui permet de diriger cette attention et d’optimiser nos capacités visuelles (e.g. mieux synchroniser ces aires). Une intervention ciblée sur certaines d’entre elles pour booster cette capacité participe d’une vision augmentée. L’équipe Frontlab à l’Institut du Cerveau utilise une stimulation magnétique transcrânienne [15], moins intrusive et plus accessible que les électrodes, qui pourrait être étendue ici. Mais qu’entend-on alors par vision augmentée ?

(a) Principe d’une vision augmentée (phosphènes) par électrodes (e.g. Utah Probe) avec comme entrée le monde réel ou cybernétique [16], (b) matrice d’électrodes et interface intégrée (http://www.blackrockneurotech.com), (c) exemple d’électrode élémentaire en oxyde de graphène tiré de [17].

3. Vision augmentée — prééminence de la réalité mixte

Il ne s’agit point ici de créer un nouveau sens dont l’être humain ne disposerait pas (e.g. doter notre rétine d’une sensibilité à l’infra-rouge), mais d’adjoindre, superposer à la vision naturelle quelque chose de plus. Il peut s’agir d’informations symboliques, d’images, de sous-titres, voire d’avatars s’intégrant dans notre champ visuel. Les dispositifs de réalité mixte (e.g. lunettes ou casques) mélangeant contenus numériques au monde réel, en sont la meilleure illustration [18]. Il suffit d’insérer dans le parcours visuel, une lame semi-transparente, qui tout en laissant la perception du monde réel, y superpose des images issues d’un système de projection externe. On trouve, par exemple, de tels dispositifs de nos jours dans la plupart des automobiles. Rien de très nouveau si la pression des composantes les plus mercantiles de la cybersphère et les progrès technologiques ne poussaient à rapprocher l’information au plus près de l’utilisateur (Near Eye Display — NED), i.e. de notre rétine et de notre œil, pour nous maintenir sous un débit constant d’information, en préservant notre mobilité. Un autre marqueur clé de cette tendance, au-delà de la plus grande complexité et richesse des contenus visuels proposés, est de solliciter de l’utilisateur des interventions haptiques sur ces objets comme le montre la figure ci-dessus. Il peut s’agir de manipuler des objets virtuels, d’activer un menu, de désigner une cible, l’œil pouvant, avec certains dispositifs très avancés, intervenir comme curseur ou actionneur dans une logique 100% mains libres. La Figure 4 montre ce que verra l’opérateur d’une chaine d’assemblage assistée du futur [19]. Outre le contrôle du poste d’assemblage (une chaudière ici), se superposent dans son champ visuel les versions numériques de pièces à assembler, les instructions d’assemblage (menu incrusté, interactif, déroulant) avec possibilité de manipuler des objets virtuels dans l’espace, tout en assemblant des pièces réelles, en conservant une vigilance et un contrôle du champ visuel attentionnel immédiat.

Illustration sur une chaîne de montage (a), tirée des guides 365 de Microsoft (l’attention est portée de la chaîne de montage aux instructions puis au plateau de la pièce), (b), avec présence d’avatars (main) dans le cadre du projet IronMen [19].

On comprend que la stimulation sensorielle change complètement de nature, mettant notre système perceptif à rude épreuve, en particulier si la cadence augmente à des fins de productivité (version 5.0 des temps modernes de Chaplin) [20]. Le potentiel d’affichage des contenus de réalité mixte que peut produire la technologie aujourd’hui dépasse largement les capacités de notre cerveau à les appréhender et analyser, sachant que tout cela ne transite que par quelques mm2 de tissu épithélial rétinien. La vision augmentée telle que produite par les fournisseurs de contenus et de technologies, avec une résolution de 0,5 pixel par seconde d’arc (susceptible d’être améliorée), est très en avance par rapport au recul que nous avons sur l’impact de tels flux de contenus sur notre système sensoriel et cognitif.

Nous pouvons toutefois en avoir une idée grâce aux études menées sur les HUD (Head Up Display en anglais) qui laissent penser que les informations produites et celles du monde réel appartiennent à deux groupes perceptifs distincts [21] et que le passage de l’un à l’autre peut entraîner des coûts attentionnels et des temps de réaction plus longs. Ces effets sont considérablement amplifiés lors de visualisations impliquant des sollicitations haptiques, pouvant conduire à une cécité attentionnelle [22], un phénomène qui se traduit par une fixation des ressources cognitives sur un seul groupe d’informations, affectant ainsi la capacité du système visuel à détecter et à répondre rapidement à des événements extérieurs à ce groupe [23]. Ce défaut d’attention s’explique par la capacité de traitement limitée du système cognitif, qui ne permet pas de traiter simultanément des informations provenant de différents groupes perceptifs. Même si l’on peut penser que le réalisme des avatars visuels sera bientôt tel que le cerveau fera difficilement la différence entre virtuel et réel, une telle distinction repose davantage sur la nature des opérations associées à ces percepts visuels interprétés à un autre niveau. Un exemple est la dichotomie entre la planification d’une action et son contrôle en ligne, suggérant que chacune sert un objectif spécifique avec des présentations visuelles distinctes [24]. La planification est influencée par un large éventail de données visuelles et cognitives, alors que le contrôle dépend principalement des caractéristiques visuelles de la cible (taille, orientation, couleur, forme). Des données neuropsychologiques et d’imagerie suggèrent que ces opérations sont desservies par des centres visuels distincts dans les lobes pariétaux postérieurs [25]. La question reste loin d’être simple et constitue un champ actuel d’investigations en neurosciences. Au stade actuel des connaissances, le traitement de scènes augmentées riches peut exiger des ressources cognitives supplémentaires avec un résultat incertain sur nos performances visuelles et capacité à répondre rapidement à ces stimuli visuels. L’objectif d’une augmentation de nos performances risquerait alors d’être manqué.

Doit-on en conclure que l’œil est le maillon faible ? Il est certes le point de passage entre percepts d’un univers mixte fortement enrichi et des mécanismes cognitifs formés par des millénaires d’évolution à une représentation du monde naturel. Même si l’on sait la plasticité de notre cerveau (les concepteurs de jeux développent une accommodation cognitive à ces contenus mixtes qui les rend plus résilients), notre cortex visuel peut peiner à assimiler une telle complexité. De nombreuses études montrent des résultats contradictoires et la question reste ouverte [26]. L’intrusion d’un univers cybernétique dans notre espace sensoriel naturel requiert un apprentissage pour prévenir d’éventuels conflits entre stimuli visuels de différentes natures, de plus en plus complexes (signes, messages incrustés dans le monde réel, etc.) et mécanismes de perception, héritage d’un long processus d’évolution. Qualifier l’œil de maillon faible est donc volontairement provocateur. La surcharge cognitive, conduisant par exemple à une forme de cécité attentionnelle, a des causes se situant clairement au niveau du cortex. La thèse visant à préconiser une stimulation directe des aires du cortex strié, court-circuitant la rétine, est donc tentante. Permettrait-elle de résoudre de tels conflits et par là même augmenter nos performances perceptives ? La question mérite d’être posée.

On ne peut toutefois se limiter à la seule capacité rétinienne, sachant l’importance des mouvements oculaires et de la tête dans la perception (un exemple est la reconstitution du relief par parallaxe de mouvement, en vison monoculaire). Il faut considérer le flux visuel incluant ces mouvements volontaires ou involontaires, pour une bonne compréhension et optimisation de la faculté cognitive. Mieux comprendre leur rôle impose un contrôle précis de la stimulation rétinienne, intégrant les mécanismes oculomoteurs, pour assimiler l’information efficacement et espérer ainsi réduire d’éventuels troubles attentionnels. Une médiation entre le cerveau et cet univers réel-cybernétique, affranchie de ces mouvements est donc pertinente pour l’étude de ces mécanismes.

Les implants corticaux le permettent, une lentille de contact instrumentée aussi. Le fait qu’elles offrent une stimulation rétinienne, affranchie des mouvements oculaires, constitue une étape intermédiaire, moins intrusive que les implants, pour réaliser des interfaces cerveau-machine (BCI en anglais). Elles constituent la troisième catégorie d’assistants visuels offrant une connexion naturelle à la cyber-sphère.

4. La lentille de contact comme assistant visuel

Les premières lentilles de contact instrumentées (incluant fonctions électroniques, physico-chimiques, etc.) ont une quinzaine d’années. Elles répondaient aux besoins de dispositifs ergonomiques d’assistance thérapeutique et au diagnostic [27]. La suite a vu l’émergence de capteurs biométriques commerciaux pour le suivi des maladies en temps réel [28] comme la lentille Verily qui détecte la glycémie dans les larmes, ou le Triggerfish de Sensimed qui mesure les variations de pression oculaire 24 h/24 pour le traitement du glaucome. Ces lentilles sont souvent associées aujourd’hui aux techniques d’élution de médicaments oculaires.

4.1. La lentille IHM visuel

Leur utilisation comme IHM date de quelques années, soit pour doter l’œil de nouvelles fonctionnalités (curseur, actionneur etc.), soit comme interface pour la réalité mixte. Citons par exemple la lentille Sony [29] qui propose d’enregistrer ce que l’utilisateur voit, à partir d’une nano-caméra, ce qui témoigne du haut niveau de miniaturisation des caméras projecteurs et afficheurs actuels, laissant penser que bientôt l’utilisateur pourra prendre des photos avec ses yeux, lire des vidéos, ouvrir des navigateurs Web, dans sa ligne de vue, et que ces cyborgs remplaceront nos smartphones. Ceci atteste de l’intérêt porté aux technologies facilitant cette nouvelle expérience de la réalité mixte, sur lentille de contact, permettant un accès aux menus dans la vision périphérique, ou de sélectionner une fonctionnalité spécifique en se concentrant sur elle. EPGL et InWith ont annoncé la construction d’InLens1.0 une lentille electronic-augmented mobile autofocus compatible avec les systèmes d’exploitation Apple iOS et Google Android [30]. Mojo-Vision propose une solution pour la RA avec un micro afficheur pupillaire [31]. Même si rien de totalement convaincant n’a encore vu le jour, cela témoigne des tendances sachant que la plupart des briques de base ont été testées.

IMT Atlantique est un des pionniers dans ce secteur en émergence. Nous avons testé l’encapsulation de plusieurs briques de base (micro-batteries flexibles [32], circuits de communication de données [33] par protocole de communication en champ proche (NFC en anglais), ASIC2 et photodiodes pour un calcul de barycentre [34]) ainsi que des fonctions complètes (double pointeur laser [35], oculomètre, détection de clignement d’œil [36]). Nous comptons également parmi les rares à effectuer des tests de biocompatibilité (marquage CE de notre pointeur laser). La Figure 5 illustre quelques fonctions clés encapsulées dans des lentilles de contact sclérales conditionnées par la société Laboratoire-LCS.

Lentilles incorporant (a) batterie flexible alimentant une LED externe [32], (b) circuit intégré ASIC et 4 photodiodes [34], (c) antenne sur monture de lunettes et sur œil artificiel [37], (d) circuit NFC [33], (e) double pointeur laser à 850 nm [35], (f) avec hologramme [38], (g) pointeur laser couplé à un casque de RA (Hololens2).

Arrêtons-nous un instant sur le protocole de transmission NFC/RFID. Son rôle est double : ressourcer la lentille (couplage par induction magnétique Figure 5c) et échanger des données avec elle, au moyen de deux antennes, une sur la lentille, l’autre à proximité (e.g. sur une lunette). Les échanges sont bidirectionnels [34]. Cette technologie est très miniaturisée de nos jours. Des Tag NFC/RFID passifs de faible consommation sont incorporés dans des biocapteurs patch [39]. Ces transpondeurs sont le signe d’une connexion potentielle à la cyber-sphère permettant l’échange avec n’importe quel medium numérique, tel qu’on peut les concevoir aujourd’hui. Ils sont intégrables facilement dans une lentille de contact et pourraient se substituer aux cellules photovoltaïques des implants rétiniens vus plus haut, pour alimenter la rétine en images de synthèse. Leur miniaturisation les rend compatibles avec la microchirurgie. La réalisation d’antennes par dépôt métallique par jet d’encre sur substrat flexible biocompatible le permet. Outre ce lien naturel à la cyber-sphère, ils affranchiraient ces implants d’un asservissement oculaire, restituant ainsi au porteur une complète mobilité.

Très récemment nous avons incorporé des hologrammes (1 mm2 sur 100 μm d’épaisseur) pour projeter des icônes, soit sur la rétine, soit vers l’extérieur pour activer des capteurs à la périphérie d’un casque AR (Figure 6b) où pour désigner des cibles visuelles [38]. Cette fonction est une fonction clé permettant à la lentille de communiquer des consignes à un système de réalité mixte représenté ici par son écran semi-transparent, équipé de réseaux de capteurs pour analyser la position des yeux (Figure 6).

(a) Exemple de fonctions déjà intégrées dans une lentille instrumentée, (b) exemple d’échange avec un casque de réalité augmentée du type Hololens2 (photo Figure 5g), (c) exemple de lentille PRAR.

4.2. La lentille PRAR

La capacité d’imager sur la rétine des icônes à partir de la lentille, superposées à la vision naturelle (Perifoveal Retinal Augmented Reality PRAR en anglais) est l’étape clé vers une lentille Cyborg RA. Si le nombre d’images à ce stade est encore limité, elle contrôle la projection sur des zones rétiniennes spécifiques, de motifs activés à distance (e.g. par GPS comme en [9]). Nous avons déjà réalisé une preuve de concept à l’échelle 2 [40] (Figure 7). La lentille comporte 8 hologrammes (couvrant partiellement l’iris) éclairés par des lasers. Les lasers sont connectés à un guide de lumière annulaire, projetant des images monochromes sur la parafovéa (Figure 6c). Les images, les aires stimulées, les couleurs et les temps d’exposition font l’objet d’études menées avec l’Institut de la Vision. Elles portent sur des situations d’exposition riches exigeant une optimisation des ressources attentionnelles.

Lentille PRAR, (a) principe et réalisation à l’échelle 2, (b) position des lasers, hologrammes et du guide de lumière, (c) aire de projection d’un motif holographique (signe de danger) sur la para-fovéa.

Les motifs sont choisis en lien avec le contexte applicatif, pour une re-stimulation attentionnelle en cas de surcharge cognitive ou de fixations prolongées entraînant des effets de masquage attentionnel. La lentille stimule les zones rétiniennes avec des icônes ou symboles indépendamment du mouvement de l’œil. Ce point est important lorsqu’il faut maintenir l’attention sur des objets ou parties de scènes, sans être gêné par des distracteurs ou améliorer des performances visuelles chez des patients atteints d’une perte de vision centrale, en stimulant, par exemple, leur locus rétinien préféré [5]. Le PRAR permet d’exécuter des commandes visuelles ou percevoir des avertissements externes sans mouvement de l’œil pour analyser d’autres zones du champ visuel. Les mouvements oculaires sont une partie de la boucle vision-action, cruciale pour l’apprentissage et la vigilance (Figure 8). Les interactions entre les yeux et le thalamus impliquent un important mécanisme de réaction événementielle où les yeux jouent un rôle clé. Le principe d’une stimulation affranchie des mouvements oculaires est une voie exploratoire innovante pour mieux comprendre leur rôle sur la gestion de la surcharge cognitive, comme déjà évoqué.

Ce que voit le porteur. Le système signale l’arrivée d’un piéton dissimulé. Un signal danger apparaît, le piéton va traverser la route, le signal disparaît une fois le piéton passé (extrait de la vidéo de [40]).

Même s’il n’agit que sur la rétine, le PRAR présente des similitudes avec les implants corticaux (Section 2.3). Il stimule des aires rétiniennes avec des formes élémentaires, certes en nombre limité (les phosphènes le sont aussi) mais suffisantes pour des fonctions de vigilance attentionnelle. Il permet la projection sur des aires prédéterminées (liées à une fonction rétinienne) avec une couleur et un temps d’exposition contrôlés, pour éviter d’éventuels troubles résiduels. Les deux approches sont pilotables par un organe externe ce qui en fait d’authentiques cyborgs. Si les icônes sont en nombre limité, leurs combinaisons produisent en grand nombre de messages différents. Ainsi si 4 hologrammes génèrent 15 associations différentes avec le double on en obtient 395, ce qui est suffisant pour fournir au cerveau une variété de messages. On retrouve un vocabulaire proche de celui des phosphènes dans l’état actuel de la technologie. Notons que l’on peut les projeter à différents endroits de la rétine ou les concentrer dans une même zone, en ajustant leurs porteuses optiques en conséquence. Le PRAR est similaire à un afficheur tête haute (HUD) comme ceux équipant les systèmes d’aide à la conduite et qui permettent au conducteur de garder la tête haute, regard fixé sur la route, tout en ayant accès à des informations en temps réel dans leur champ visuel. Il sera d’ailleurs bientôt possible de remplacer ces hologrammes par un micro-afficheur intégré. C’est la voie que poursuit par exemple la société Mojo-vision [31].

La principale limite de cette solution est le volume exploitable, sans créer de gêne pour le porteur. Dans ce contexte, les lentilles sclérales sont les supports naturels pour ces cyborgs car elles offrent plus de surface (une partie de la sclère peut être utilisée [41]). Elles sont statiques et sans contact avec la cornée. L’utilisation de la zone pupillaire fait encore débat. Certains considèrent qu’elle doit rester libre pour assurer une qualité de vision ophthalmique et pour des raisons de sécurité. Le développement de l’électronique graphène laisse penser que cette zone (15 à 20% de volume supplémentaire) sera bientôt utilisable. Il parait difficile d’aller plus loin et dès lors de penser qu’une lentille cyborg puisse un jour remplacer les fonctionnalités d’un casque ou de lunettes RA. Elles ont davantage leur place comme relai ou assistant visuel. Pour une stimulation rétinienne ciblée, elles sont des outils d’investigation de choix. La fusion de l’attention visuelle avec des tâches de désignation est de très grand intérêt pour de nombreuses applications. La possibilité d’une désignation visuelle contribue en effet à alléger la charge de travail des opérateurs, leur permettant de se concentrer sur leur mission principale tout en établissant un nouveau lien entre la planification, les fonctionnalités de contrôle et la coordination sensorielle [24].

5. Conclusions et limites de l’exercice

Ces quelques lignes pourraient donner à penser que l’œil humain serait le frein principal à une forme d’hyper-sensorialité visuelle et un obstacle au déploiement d’une vision cybernétique (i.e. une vision augmentée riche). Les évolutionnistes ont reformulé la chose autrement : pourquoi ne pas avoir une plus grande fovéa ? Parce que les connexions et l’espace cortical nécessaires pour traiter tout le champ visuel de manière aussi détaillée que la fovéa, nécessiteraient un cerveau plus volumineux que le cerveau humain. Cette remarque peut faire écho à l’observation de certains troubles lors d’une exposition intensive et incontrôlés à des contenus de réalité mixte riches. Les causes, toutefois, en sont multiples (modèles variés d’éclairage, de mise en contexte, de mouvements etc.). La fusion des mondes réels et virtuels est un sujet complexe qui fait l’objet de nos jours de nombreux travaux [42].

Il existe donc une limite naturelle à l’emploi de cyborgs connectés à notre cortex ou système visuel, sans pour autant que cela n’empêche des usages avantageux tels que pour la restauration et le traitement de troubles visuels et de la cécité. Le déploiement d’une vision augmentée cybernétique se heurte par contre à un modèle purement évolutionniste de l’être humain [37], reposant sur la plasticité du cerveau, sa capacité à apprendre et à s’adapter. Devant la crainte de l’accélération d’une forme intelligence artificielle portée par une technologie dont la loi de croissance suit une autre échelle de temps laissant penser qu’elle devrait dépasser assez vite la capacité du cerveau humain, l’idée de greffes cybernétiques semble être pour certains la seule réponse à apporter à cette apparente menace. Certaines de ces thèses véhiculées par le nouveau courant transhumaniste américain (influencé par une culture littéraire et cinématographique inépuisable) prônent le remplacement de l’œil biologique par un œil artificiel, postulant, que hormis le cerveau, la biotechnologie pourra bientôt fabriquer membres, organes, capteurs (e.g. exosquelette, valve cardiaque, implant cochléaire, etc.), autant de pièces détachées usables, mais remplaçables. On peut penser qu’une telle perspective n’enthousiasme pas la profession, mais elle ne peut être écartée et participe pleinement d’une réflexion globale sur la vision augmentée cybernétique.

Serions-nous entrés dans l’ère d’Homo-Machinus-Cyberneticus [43] ? Le foisonnement d’hypothèses, parfois parmi les plus fantaisistes, alimenté par les séries SF et internet, est très fécond. S’il participe du génie créatif humain, aujourd’hui plus que jamais, nombre de ces hypothèses sont technologiquement envisageables. Certaines dépassent même l’imaginable, ce qui exige un réel sens de l’anticipation. Si l’idée de devenir des hommes augmentés, tel un Steve Austin3 , reste un vieux rêve, on peut s’interroger sur la façon de mettre à profit cette ingénierie cyborg. Au-delà de l’opposition restauration-augmentation, on peut les voir comme de formidables outils d’investigation pour les neurosciences, pour mieux analyser les mécanismes de perception, de cognition, d’apprentissage, portant sur l’un des organes neurosensoriels parmi les plus développés et les plus complexes : la vision humaine. Dans ce but, les lentilles de contact instrumentées pourraient être l’étape clé d’une expérimentation maitrisée et progressive. Outre leur caractère peu intrusif facilitant l’expérimentation sur l’humain, le volume limité de ce qui est intégrable est une garantie face aux ambitions de futurs démiurges et une migration contrôlée vers des organes cybernétiquement augmentés plus intrusifs, avant qu’ils ne deviennent des consommables. La troisième voie est peut-être celle des sciences. La véritable nouveauté de ces objets est le champ scientifique multidisciplinaire sur lequel ils reposent, carrefour des nanotechnologies, biotechnologies, technologies de l’information et sciences cognitives. Sous ce rapport ils sont emblématiques d’une convergence entre infiniment petit, fabrication du vivant, machines pensantes et étude du cerveau humain, symbole de la mutation que connait notre société industrielle aujourd’hui.

Conflit d’intérêt

L’auteur n’a aucun conflit d’intérêt à déclarer.

1 Appearance of bright spots in the visual field, even with the eyes closed.

2 Application-Specific-Integrated Circuit.

3 Hero of a successful TV series from the 1970s “The six million dollar man”.

1 Apparition de taches lumineuses dans le champ visuel, y compris les yeux fermés.

2 Application-specific integrated circuit ou circuit intégré spécialisé.

3 Héros d’une série TV à succès des années 70 « L’homme qui valait 3 milliards ».

CC-BY 4.0

CC-BY 4.0